Los científicos acorralan al bosón de Higgs

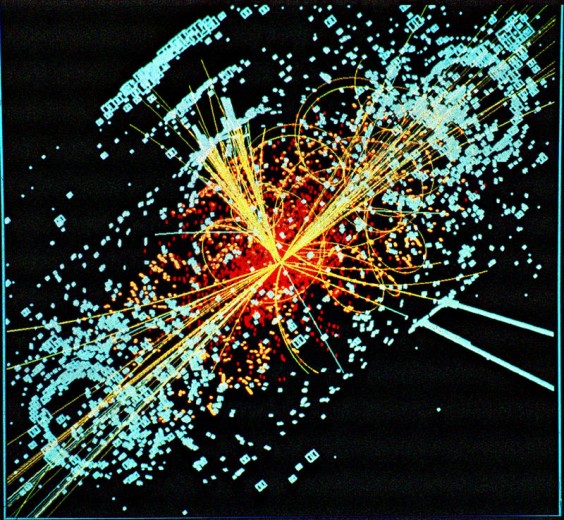

Simulación del bosón de Higgs. (Imagen: CERN/CPAN)

Si existe el esquivo bosón de Higgs, una partícula que los científicos se afanan en descubrir para completar el Modelo Estándar de Física de Partículas, su rango de masas está entre unos 115 y 130 gigaelectronvoltios (GeV). Esto supone un avance “significativo” en la búsqueda, según los investigadores de los experimentos CMS y ATLAS que acaban de presentar los datos en la sede de la Organización Europea para la Investigación Nuclear (CERN). La comunidad científica confía en que a finales de 2012 quede aclarado si existe o no el bosón de Higgs.

"Las colaboraciones ATLAS y CMS (los dos mayores experimentos del Gran Colisionador de Hadrones o LHC) han conseguido excluir con los datos coleccionados en 2011 masas del Higgs en el modelo estándar por encima de unos 127 GeV, lo cual representa un gran avance en esta búsqueda", explica a SINC Juan Alcaraz, investigador principal del CIEMAT en el CMS.

Cintíficos de los experimentos ATLAS y CMS han presentado en un seminario en el CERN el estado de su búsqueda del bosón de Higgs que predice el Modelo Estándar de Física de Partículas. Sus resultados se basan en el análisis de una cantidad de datos considerablemente mayor que la de los resultados que se presentaron en las conferencias del pasado verano, cantidad suficiente para hacer progresos significativos en la búsqueda del bosón de Higgs, pero no para hacer una afirmación rotunda sobre la existencia o no de esta elusiva partícula.

"En el intervalo de masas 114-127 GeV, ambas colaboraciones ven ligeros excesos, particularmente en el canal de desintegración de dos fotones y para masas en la zona 124-126 GeV, pero la cantidad de datos recogidos hasta la fecha no es suficiente para poder determinar si se trata realmente de la partícula Higgs o de simples fluctuaciones estadísticas algo superiores a lo esperado", aclara Alcaraz.

El investigador contextualiza el avance: "Estas fluctuaciones son del orden de unas 2-3 desviaciones estándar, y la práctica común en el caso de descubrimiento de nuevas partículas dicta la observación de al menos 5 desviaciones estándar, lo que aseguraría que se trata de un exceso estable. Cabe destacar que hay pocas diferencias entre las capacidades de ATLAS y CMS en cuanto a la detección del Higgs se refiere. Las fluctuaciones estadísticas en esta búsqueda son en este momento más importantes que pequeñas diferencias en las características de cada experimento".

De momento, la principal conclusión es que si existe el bosón de Higgs su rango de masas más probable está entre 116 y 130 GeV, según el experimento ATLAS, y entre 115 y 127 GeV, según CMS. Ambos experimentos han visto indicios en la misma región de masas, pero no lo bastante sólidos para ser considerados un descubrimiento.

El bosón de Higgs, de existir, tiene una duración muy breve y se desintegra en muchas formas distintas. Su descubrimiento se basa en observar las partículas en las que se desintegra más que el propio bosón de Higgs. Tanto ATLAS como CMS han analizado varios canales de desintegración, y han visto pequeños excesos en la región de baja masa donde la presencia del bosón de Higgs aún no había sido excluida.

Por separado, ninguno de estos excesos es más significativo estadísticamente que lanzar un dado y sacar dos seis consecutivos. Lo interesante es que hay diferentes medidas independientes que señalan a la región entre 124 y 126 GeV. Es aún muy pronto para decir si ATLAS y CMS han descubierto el bosón de Higgs, pero estos resultados actualizados están generando un gran interés en la comunidad científica de física de partículas.

“Hemos restringido la región de masas más probable para el bosón de Higgs de 116 a 130 GeV, y en las últimas semanas hemos empezado a ver un fascinante exceso de eventos en el rango de masas alrededor de 125 GeV”, explica la portavoz del experimento ATLAS Fabiola Gianotti. “Este exceso puede deberse a una fluctuación, pero también podría ser algo más interesante. En este punto no podemos concluir nada. Necesitamos estudiar más datos. Dado el excepcional funcionamiento del LHC este año, no tendremos que esperar mucho para tener datos suficientes y esperamos resolver este puzle en 2012”.

“No podemos excluir la presencia del bosón de Higgs del Modelo Estándar entre 115 y 127 GeV debido a un modesto exceso de eventos en esta región de masa que aparece, bastante consistentemente, en cinco canales de desintegración diferentes”, señala el portavoz de CMS, Guido Tonelli. “El exceso es más compatible con un bosón de Higgs del Modelo Estándar en la proximidad de los 124 GeV y por debajo, pero la significancia estadística no es lo suficientemente grande como para decir algo concluyente. Lo que vemos hoy es consistente tanto con una fluctuación de fondo o con la presencia del bosón. Análisis más refinados y los datos adicionales que aporte el LHC en 2012 darán definitivamente una respuesta”.

En los próximos meses, ambos experimentos refinarán aún más sus análisis de cara a las conferencias de invierno de física de partículas previstas para marzo. Sin embargo, una declaración definitiva sobre la existencia o no del bosón de Higgs requerirá más datos, y no es probable que se produzca hasta el final del año que viene.

"El próximo paso es el análisis de los datos que el LHC proporcionará en 2012, entre 10 y 20 femtobarn inversos, esto es, de dos a cuatro veces la cantidad de datos actual, y esta nueva muestra debería permitir confirmar o refutar la existencia de este exceso", adelanta Alcaraz. "En el caso de confirmarse la existencia de una señal, el paso siguiente sería determinar con mayor precisión si la cantidad de sucesos es consistente con lo predicho por el Modelo Estándar, cuál es su masa y otras propiedades (¿es realmente su espín cero?). Pero si se confirma que se trata de una simple fluctuación estadística, la búsqueda proseguiría hasta la masa más baja posible (114 GeV)".

Si no se observara el bosón de Higgs, se continuaría la búsqueda en otros modelos. En muchos de los modelos populares que lo extienden, se espera no ya un sólo campo de Higgs, sino al menos dos, con una posible reducción de la cantidad de sucesos esperados. El Higgs podría tener también acoplos diferentes a otras partículas, de tal forma que los canales considerados como más probables pudieran no serlo en realidad.

Incluso bajo la hipótesis de una ausencia completa de señal en el intervalo de masas 114-600 GeV, es ineludible la presencia de algo con propiedades semejantes al bosón de Higgs. Su ausencia a baja masa se manifestaría entonces en el LHC como un incremento detectable de la producción de pares de bosones a altas energías de colisión y posiblemente daría lugar a nuevas estructuras en el espectro de masas en la zona de los miles de GeV.

El Modelo Estándar es la teoría que los físicos usan para describir el comportamiento de las partículas fundamentales y las fuerzas que actúan entre ellas. Describe la materia ordinaria de la cual estamos compuestos nosotros y todo lo observable. Sin embargo, no describe el 96% del universo, que es invisible. Uno de los objetivos principales del programa de investigación del LHC es ir más allá de este modelo, y el bosón de Higgs podría ser la llave.

Este bosón confirmaría esta teoría, presentada por primera vez en la década de los sesenta, pero podría tomar otras formas relacionadas con teorías que van más allá. Un bosón de Higgs dentro del Modelo Estándar podría seguir señalando a nueva física mediante sutilezas en su comportamiento que sólo surgirían después de estudiar un gran número de desintegraciones de esta partícula.

Pero si estuviera fuera, la ausencia del bosón de Higgs del Modelo Estándar señalaría enormemente la presencia de nueva física en el rango de energía para el que está diseñado el LHC, 14 TeV (teraelectronvoltios), que se espera alcanzar después de 2014. Tanto si ATLAS y CMS muestran en los próximos meses que el bosón de Higgs del Modelo Estándar existe o no, el programa del LHC está abriendo el camino a una nueva física.

"Sea cual sea la continuación, no cabe duda que el LHC representará un gran gran primer paso en la comprensión de ese concepto tan natural pero a la vez tan oscuro: la masa", concluye Juan Alcaraz.

El bosón de Higgs es la única partícula aún no descubierta del denominado modelo estándar. Es una partícula sumamente especial, esencial en el Modelo Estandar para explicar la unificación entre fuerzas electromagnéticas y débiles, así como la existencia de partículas con masa, tal y como observamos en el universo que nos rodea. Su búsqueda en el LHC se ha focalizado en la región de masas comprendida entre 114 y 600 giga-electrón voltios (GeV), siendo 1 GeV aproximadamente la masa de un protón. La masa de 114 GeV corresponde al límite inferior establecido por los experimentos de LEP, el gran colisionador electrón-positrón del CERN, que ocupó en el pasado el túnel que ahora ocupa el LHC. La masa de 600 GeV corresponde al límite a partir del cual se considera que el Higgs no se puede tratar como una partícula propiamente dicha, al tener una probabilidad de desintegración excesivamente elevada, así como la masa a partir de la cual aparecerían dificultades de interpretación dentro del modelo estándar. La luminosidad integrada que han coleccionado los experimentos ATLAS y CMS, cercana a los 5 femtobarn inversos, ya es suficiente para realizar una búsqueda eficiente del bosón de Higgs en el intervalo de masas citado. (Para hacernos una idea, un femtobarn inverso representa algo cercano a unos 300 millones de sucesos analizados en un detector como CMS.)

El Higgs es una partícula inestable, que se desintegra inmediatamente en otras partículas en el mismo punto de colisión de protones. Dependiendo de la hipótesis de masa estudiada, hay canales de desintegración más convenientes que otros. En el intervalo de masas por encima de 130-140 GeV, los canales más eficaces par la búsqueda corresponden a la desintegración del Higgs en pares de bosones W ó Z, con posterior descomposición en cuatro leptones o dos leptones y dos quarks.

En el intervalo de baja masa, 114-130 GeV, el canal más prometedor es la desintegración del Higgs en un par de fotones que, si bien es una canal poco probable, está mucho menos afectado por procesos de fondo que otros. Hay que destacar que estos análisis buscan señales de unas decenas de sucesos sobre un total de millones y que, incluso después de aplicar criterios de selección estrictos, se termina buscando un pequeño exceso sobre un fondo de centenas o miles de sucesos.

Desde la puesta en marcha del detector ATLAS, donde participan 3.000 científicos de 174 instituciones procedentes de 38 países, investigadores del Instituto de Física Corpuscular (IFIC), centro mixto del Consejo Superior de Investigaciones Científicas (CSIC) y la Universitat de València; el Institut de Fisica d'Altes Energies (IFAE), consorcio entre la Generalitat de Catalunya y la Universitat Autònoma de Barcelona; el Instituto de Microelectrónica de Barcelona (CNM‐IMB‐CSIC); y la Universidad Autónoma de Madrid (UAM), participan activamente en la operación y mantenimiento de los detectores, con una fuerte presencia en las actividades de alineamiento y calibración.

Dentro del amplio programa de investigación del LHC, los grupos españoles en ATLAS participan en un gran número de líneas de investigación en el análisis de los datos, que cubren muchos de los temas a priori más interesantes del programa del LHC. En particular, en el caso de la búsqueda del bosón de Higgs del Modelo Estándar, los grupos han estudiado diferentes estados finales resultado de la desintegración de la partícula de Higgs en dos fotones, dos leptones taus, y dos bosones Z o W.

Por su parte, en CMS, donde participan 3.000 científicos de 172 institutos en 40 países, están presentes grupos experimentales del Instituto de Física de Cantabria (IFCA), centro mixto CSIC-Universidad de Cantabria; la Universidad de Oviedo; el Centro de Investigaciones Energéticas, Medioambientales y Tecnológicas (CIEMAT); y la Universidad Autónoma de Madrid (UAM), que participan en la búsqueda del bosón de Higgs. Destaca la relevante participación de los investigadores de la Universidad de Oviedo y del IFCA en el análisis del canal de desintegración del bosón de Higgs en bosones WW, y de los investigadores del CIEMAT en el canal de desintegración en bosones ZZ, ambos muy relevantes en esta búsqueda y que han sido claves para excluir que su masa se encuentre entre 127 y 600 GeV.

La participación de los grupos de investigación españoles en el LHC cuenta con el apoyo del Ministerio de Ciencia e Innovación a través del Programa Nacional de Física de Partículas y del Centro Nacional de Física de Partículas, Astropartículas y Nuclear (CPAN), proyecto Consolider-Ingenio 2010 cuyos principales objetivos son la promoción y coordinación científica de la participación española en proyectos internacionales, el desarrollo de actividades comunes de I+D y la formación e incorporación a los grupos de nuevos investigadores y técnicos. El CPAN pretende consolidar estas actuaciones mediante la constitución de un centro en red de carácter permanente, análogo a los existentes en otros países de nuestro entorno. (Fuente: CERN/CPAN)

Autor

Tema: FORO-CIENCIA (Leído 859142 veces)

Autor

Tema: FORO-CIENCIA (Leído 859142 veces)

!! ADVERTENCIAS !!: Las informaciones aquí publicadas NO CONTIENEN KEYS para la decodificación de ningún sistema: NO SON OPERATIVOS en sistemas SAT que precisen de su correspondiente suscripción. ESTA TOTALMENTE PROHIBIDO EL USO DE ESTAS INFORMACIONES PARA LA MODIFICACIÓN O DEFRAUDACIÓN DE SISTEMAS DE ACCESO CONDICIONAL. EN ESTOS FOROS NO SE PERMITE LA PUBLICACIÓN DE INFORMACIONES ILEGALES POR PARTE DE LOS USUARIOS. EN CASO DE DETECTARSE ESTE TIPO DE INFORMACIONES, LOS USUARIOS SERÁN EXCLUIDOS DE ESTAS PÁGINAS.

!! ADVERTENCIAS !!: Las informaciones aquí publicadas NO CONTIENEN KEYS para la decodificación de ningún sistema: NO SON OPERATIVOS en sistemas SAT que precisen de su correspondiente suscripción. ESTA TOTALMENTE PROHIBIDO EL USO DE ESTAS INFORMACIONES PARA LA MODIFICACIÓN O DEFRAUDACIÓN DE SISTEMAS DE ACCESO CONDICIONAL. EN ESTOS FOROS NO SE PERMITE LA PUBLICACIÓN DE INFORMACIONES ILEGALES POR PARTE DE LOS USUARIOS. EN CASO DE DETECTARSE ESTE TIPO DE INFORMACIONES, LOS USUARIOS SERÁN EXCLUIDOS DE ESTAS PÁGINAS.